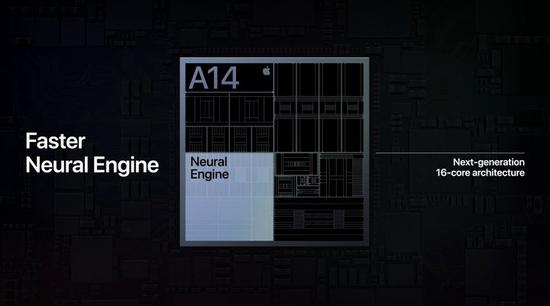

近两代的A系芯片中,神经网络引擎是一个经常会被苹果提及的模块。本次A14也不例外,神经网络引擎的内核数直接增加了一倍,从A13的8核变成了A14的16核,估计那40%的晶体管数量提升,有相当一部分都用在了这里。

而由此带来的近两倍的机器学习算力提升,也明显要比CPU、GPU升级耀眼得多,更别说还有应用在处理器上的机器学习加速器。

相比CPU和GPU,A14在机器学习算力上的提升会更明显,但这个神经网络引擎会影响哪些体验,很多人并不清楚。

我们很难把它归结为单纯的‘手机流畅度提升’,因为它不像CPU、GPU一样,可以有量化数据作为对比依据;就算是算力翻倍,它也不会让你的游戏,从原来的30帧升到60帧。

不过,近几代iOS系统内的特性,有很多都是离不开机器学习技术的。

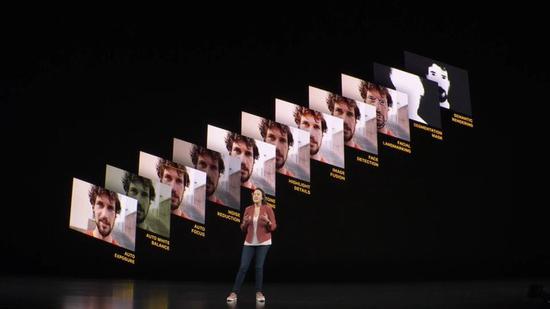

比如说拍照,去年iPhone 11 Pro引入的DeepFusion三合一图像处理技术,就是通过机器学习训练的算法,来实现图像合成,最终生成出一张更高质量的照片。

图像识别、文本概述、语义分析等,都涉及到机器学习技术的运用

更进一步,iPhone的相册能够自动根据人脸特征,对图库进行分类;还有像Apple Music能够根据我们的听歌偏好,自动推荐你喜欢的歌曲;而iPhone的电源管理系统也会主动学习我们的使用习惯,延长、优化续航时间,背后都有机器学习技术的参与。

在本次iPad Air 4中,苹果也介绍了两个使用了A14机器学习技术的案例。

一个是djayPro应用,它可以让iPadAir调用前置摄像头,捕捉、识别出音乐人打碟的手势,实现‘隔空打碟’的特性。

考虑到iPad Air 4并未搭载可感知深度场景的FaceID元件,这种动作识别,也只能靠机器学习的方案来实现。

另一个案例则是照片编辑应用Pixelmator,借助机器学习能力,它可以让被裁减、放大后的照片,实现自动修复。

哪怕是照片本身的分辨率十分有限,但机器学习依旧能填补缺失的像素点,改进边缘锯齿和图像纹理。

所以,从上述几个例子可以看到,A系芯片的神经网络引擎看似是‘感知不强’,但实际上,是它施加的影响更底层,不容易被我们察觉而已,很多功能其实与我们的使用体验是息息相关的。

去年,苹果前高管菲尔·席勒(PhilSchiller)在接受《连线》采访时也说,目前iOS系统的功能中,基本已经不存在不使用机器学习的领域了。无论是对电池寿命的影响,还是性能的优化,它一直都你所不知道的地方,持续地运行着。

既然如此,发展更强的算力,这些工作显然能更有效率地去运行;而苹果也能规避掉个人数据收集的风险,让设备只靠本地算力而非联网,就能完成更重度、更复杂的任务。